- Holger's KI-Insights Newsletter

- Posts

- Der Anfänger Guide durch den lokalen KI-Dschungel

Der Anfänger Guide durch den lokalen KI-Dschungel

Lokale KI Modelle nutzen, ohne Kosten und Datenaustausch

Wer KI lokal laufen lassen will, sieht ganz viele Fachbegriffe die kryptisch sind, die man aber verstehen sollte, um das passende lokale KI Modell auszusuchen. Deshalb der Beitrag, Licht ins Dunkel zu bekommen.

Ich hatte gestern die Aufgabe 4000 Records ins Seatable zu klassifizieren. Ich wollte nicht die Cloud Provider nutzen. Deshalb lokale KI. Ich musste ein paar Abkürzungen selber nochmal nachlesen. Ich habe von den Modellen im Post eine Auswahl genommen, es gibt im Moment tausende LLMs mit den spezifischen Tunings.

Link zu dem LinkedIn Post von mir.

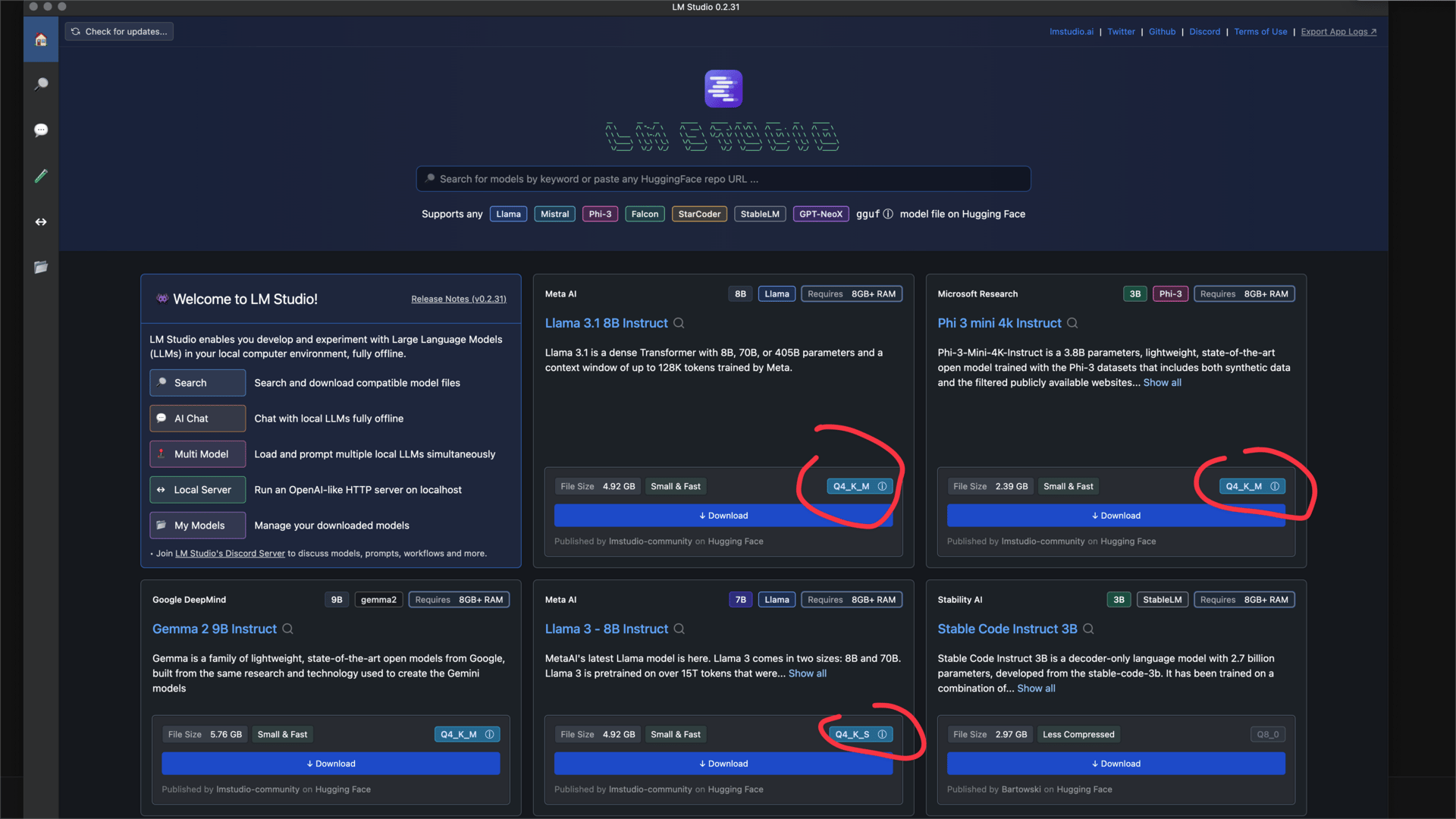

Übersicht in LLM Studio, wenn man dann ins Detail geht zu einem Modell findet man viele Optionen

🎯 Teil 1: Die Grundprinzipien verstehen

Was ist überhaupt ein LLM - das wissen jetzt alle?

LLM = Large Language Model = Großes Sprach-Modell

In einfachen Worten: Eine künstliche Intelligenz, die Sprache versteht und generieren kann. Wie ChatGPT, Claude oder Gemini – aber auf Ihrem eigenen Computer.

Beispiele (Die neuesten Modelle):

Llama 3.1 & 3.2 (von Meta/Facebook)

Qwen 2.5 (von Alibaba – aktuell der Preis-Leistungs-Sieger)

Gemma 2 (von Google – sehr menschlicher Schreibstil)

Mistral NeMo (von Mistral AI & NVIDIA)

Phi-3.5 (von Microsoft – für schwächere Hardware)

Das zentrale Problem: Modelle sind RIESIG

Hier ist das Kernproblem, um das sich alles dreht:

Ein "normales" LLM ist gigantisch:

Llama 3.1 - 8 Milliarden Parameter (8B) → Original-Größe: 16 GB → Braucht mindestens 20 GB Grafikkarten-Speicher (VRAM)

Llama 3.1 - 70 Milliarden Parameter (70B) → Original-Größe: 140 GB → Braucht mindestens 160 GB VRAM

Das Problem:

Eine RTX 4090 (Top-GPU) hat nur 24 GB VRAM

Ein Mac M2 Ultra in maximaler Stufe hat zwar 192 GB RAM, aber andere Einschränkungen

Die meisten Consumer-GPUs haben 8-16 GB

Die Lösung: KOMPRESSION (Fachbegriff: "Quantisierung")

Quantisierung: Bücher kleiner machen

Stellen Sie sich vor, Sie haben ein Lexikon mit 10.000 Seiten. Das passt nicht in Ihren Rucksack. Was tun?

Option 1: Original behalten (16-Bit / FP16)

📚 Hardcover-Lexikon, 10.000 Seiten → Perfekte Qualität → Passt nicht in den Rucksack → Sehr schwer

Option 2: Taschenbuch-Ausgabe (8-Bit)

📕 Taschenbuch, kleinerer Druck, dünneres Papier → 5.000 Seiten (halbe Größe!) → Qualität: 95% vom Original → Passt in den Rucksack

Option 3: Zusammenfassung (4-Bit) ⭐

📗 Nur die wichtigsten Infos → 2.500 Seiten (viertel Größe!) → Qualität: 80-85% vom Original → Passt easy in den Rucksack → SWEET SPOT!

Option 4: Notizen (2-Bit)

📘 Nur Stichpunkte → 1.250 Seiten → Qualität: 50-60% → ⚠️ Zu viel weggelassen!

Bei KI-Modellen funktioniert es genauso!

16-Bit (Original): 16 GB → Perfekt, aber riesig

8-Bit: 8 GB → Sehr gut

4-Bit: 4 GB → ⭐ Sweet Spot! (80-85% Qualität)

2-Bit: 2 GB → ⚠️ Zu ungenau

Warum ist 4-Bit so beliebt?

Die Goldilocks-Zone: Nicht zu groß, nicht zu klein – genau richtig!

Was Sie gewinnen | Was Sie verlieren |

|---|---|

✅ 4x weniger Speicher | ❌ ~15% Qualität |

✅ 2-3x schneller | (Kaum merkbar bei den meisten Aufgaben!) |

✅ Passt in Consumer-GPUs | |

✅ Viel günstiger |

Beispiel:Llama 3.1 8B (Original 16-Bit): → 16 GB Datei → Braucht RTX 4090 (24 GB VRAM) → Kosten: ~1.800€

Llama 3.1 8B (4-Bit komprimiert): → 4 GB Datei → Läuft auf RTX 4060 Ti (16 GB VRAM) → Kosten: ~500€ → 80% der Qualität, 30% des Preises!

📦 Teil 2: Die verschiedenen Formate verstehen

Jetzt wird's interessant! Es gibt verschiedene Methoden, um ein Modell auf 4-Bit zu komprimieren. Jede hat Vor- und Nachteile.

Think of it wie Video-Formate:

MP4 (universal, funktioniert überall)

MKV (bessere Qualität, braucht spezielle Player)

AVI (alt, aber funktioniert noch)

Bei LLMs gibt es:

GGUF (universal)

GPTQ (NVIDIA-optimiert)

EXL2 (NVIDIA-optimiert, noch besser)

AWQ (NVIDIA-optimiert, beste Qualität)

Lassen Sie mich jede erklären:

🌍 GGUF: Der Universalist

Ausgeschrieben: GPT-Generated Unified Format

Die Metapher: Das MP3 der LLM-Welt

Funktioniert überall

Nicht die beste Qualität, aber solide

Einfach zu nutzen

Eigenschaften: ✅ Funktioniert auf ALLEN Systemen:

Windows (CPU + NVIDIA/AMD GPU)

Mac (CPU + Metal GPU)

Linux (CPU + NVIDIA/AMD GPU)

✅ Ein Programm: llama.cpp / LM Studio / Ollama

Sehr populär

Große Community

Viele Tools

❌ Nicht die schnellste Option auf NVIDIA ❌ Nicht die beste Qualität bei 4-Bit

Wann GGUF nutzen?

Sie haben einen Mac

Sie haben eine AMD-Grafikkarte

Sie wollen einfach nur testen

Sie wollen maximale Kompatibilität

Erkennbar an: Dateiendung: .gguf Beispiel: Llama-3.1-8B-Q4_K_M.gguf

GGUF-Varianten entschlüsselt:

Q4_K_M

M = Medium (Qualitätsstufe)

K = K-Quants (verbesserte Methode)

Q4 = 4-Bit Kompression

Empfehlung: Für die meisten Zwecke ist Q4_K_M oder Q5_K_M perfekt!

🚀 GPTQ: Der NVIDIA-Spezialist

Ausgeschrieben: GPT Quantization

Die Metapher: Ein Turbo-Lader speziell für NVIDIA-Autos

Nur mit NVIDIA-Motoren kompatibel

Aber dann: 30-60% schneller!

Eigenschaften: ✅ SEHR schnell auf NVIDIA GPUs (RTX Serie) ✅ Nutzt spezielle Hardware (INT4 Tensor Cores) ✅ 30-60% schneller als GGUF

❌ NUR NVIDIA (CUDA) ❌ Funktioniert NICHT auf Mac ❌ Funktioniert NICHT auf AMD

Wie funktioniert GPTQ? (vereinfacht)

GGUF komprimiert jede Zahl einzeln: 3.14159 → 32.71828 → 3

GPTQ ist intelligenter – gruppiert ähnliche Zahlen: Gruppe 1: [3.14159, 2.71828] → [3.1, 2.7] ← genauer!

= Bessere Qualität bei gleicher Größe

Wann GPTQ nutzen?

Sie haben eine NVIDIA RTX GPU

Sie wollen maximale Geschwindigkeit

Sie brauchen keine Mac-Kompatibilität

Erkennbar an: Im Namen: "GPTQ" oder "4bit-128g" Dateiformat: .safetensors

⚡ EXL2: Der Intelligente

Ausgeschrieben: ExLlama2 Format

Die Metapher: Ein Smart-Packer der weiß, was wichtig ist

Wichtige Sachen: hohe Qualität (mehr Bits)

Unwichtige Sachen: niedrige Qualität (weniger Bits)

Im Durchschnitt: z.B. 4.0 Bits

Eigenschaften: ✅ Intelligenteste Kompression ✅ Variable Bits-per-Weight (bpw) ✅ Oft SCHNELLER als GPTQ ✅ BESSERE Qualität als GPTQ

❌ NUR mit exLlama2-Software ❌ NUR NVIDIA GPUs

Wie funktioniert EXL2?

Stellen Sie sich ein Orchester vor:

GPTQ: Alle Instrumente gleich aufnehmen

Violine: 4-Bit

Trommel: 4-Bit

Flöte: 4-Bit

Durchschnitt: 4-Bit

EXL2: Wichtige Instrumente besser aufnehmen!

Violine: 6-Bit ← Hauptinstrument, wichtig!

Trommel: 2-Bit ← Laut, braucht weniger Details

Flöte: 5-Bit ← Mittelwichtig

Durchschnitt: 4.3 Bits per Weight (bpw)

= Besserer Sound bei gleicher Dateigröße!

Bei LLMs:

Attention-Layer: 6-Bit ← Sehr wichtig für Verständnis!

Feed-Forward: 3-Bit ← Weniger kritisch

Durchschnitt: 4.0 bpw

Was bedeutet "bpw"? bpw = bits per weight = Bits pro Gewicht

2.5 bpw = Sehr komprimiert (niedrige Qualität)

4.0 bpw = ⭐ Sweet Spot! (gute Balance)

6.0 bpw = Hohe Qualität (fast wie Original)

Wann EXL2 nutzen?

Sie haben NVIDIA RTX GPU

Sie wollen MAXIMALE Performance

Sie sind bereit, exLlama2 zu installieren

💎 AWQ: Der Qualitäts-Champion

Ausgeschrieben: Activation-aware Weight Quantization

Die Metapher: Ein Psychologe für Ihr Modell

Beobachtet: Welche Neuronen sind am aktivsten?

Entscheidung: Aktive Neuronen weniger komprimieren!

Resultat: Beste Qualität bei 4-Bit

Eigenschaften: ✅ BESTE Qualität bei 4-Bit (5-10% besser als GPTQ) ✅ Funktioniert mit vLLM (Production-System) ✅ Ähnliche Geschwindigkeit wie GPTQ ✅ Wissenschaftlich fundiert

❌ NUR NVIDIA GPUs ❌ Weniger verbreitet als GPTQ

Wie funktioniert AWQ?

Training mit Test-Daten: Modell bekommt 1000 Beispiel-Texte. System beobachtet: Welche Neuronen feuern oft?

Wichtigkeit messen: Neuron A (95% aktiv) ist WICHTIG. Neuron C (5% aktiv) ist unwichtig.

Intelligente Kompression: Neuron A bekommt 6-Bit, Neuron C nur 2-Bit.

Das Ergebnis:

Gleiche Dateigröße wie GPTQ

Aber 5-10% bessere Qualität!

Besonders gut bei: Reasoning, Math, Code

📊 Format-Vergleich auf einen Blick

Die 4 Formate im direkten Vergleich:

Format | Geschwindigkeit | Qualität | Kompatibilität | Für wen? |

|---|---|---|---|---|

GGUF | ⭐⭐⭐ Mittel | ⭐⭐⭐⭐ Gut | ⭐⭐⭐⭐⭐ Überall | Mac, AMD, Anfänger |

GPTQ | ⭐⭐⭐⭐⭐ Sehr schnell | ⭐⭐⭐ OK | ⭐⭐ Nur NVIDIA | NVIDIA-User, Speed |

EXL2 | ⭐⭐⭐⭐⭐ Sehr schnell | ⭐⭐⭐⭐ Gut | ⭐⭐ Nur NVIDIA | Max. Performance |

AWQ | ⭐⭐⭐⭐ Schnell | ⭐⭐⭐⭐⭐ Sehr gut | ⭐⭐ Nur NVIDIA | Production, Qualität |

Konkrete Zahlen: Llama 3.1 8B auf RTX 4090

Format | VRAM | Geschwindigkeit | Qualität | Empfehlung |

|---|---|---|---|---|

Original (16-Bit) | 16 GB | 131 tok/s | 100% | Nur für Forschung |

GGUF Q4_K_M | 5 GB | 100 tok/s | 85% | ✅ Mac/AMD |

GPTQ 4-bit | 5 GB | 185 tok/s | 80% | ✅ Speed |

EXL2 4.0 bpw | 5 GB | 211 tok/s | 85% | ⭐ Best Choice! |

AWQ 4-bit | 5 GB | 150 tok/s | 90% | ✅ Production |

Fazit: Auf NVIDIA GPUs ist EXL2 der Gewinner für Geschwindigkeit, AWQ für Qualität!

Wie kann ich ein lokales Modell installieren? Hier eine schöne Übersicht

🎯 Teil 3: Die 5 Use Cases (Update 2025)

Jetzt wird's praktisch! Hier sind 5 konkrete Anwendungsfälle – und was Sie jeweils brauchen. (Aktualisiert mit den besten Modellen Stand Ende 2024).

USE CASE 1: Persönlicher Coding-Assistent

Was wollen Sie erreichen?

Code-Vorschläge in Ihrer IDE

Bugs finden und erklären

Code in verschiedenen Sprachen generieren

Alles offline und privat

Warum brauchen Sie das?

Keine monatlichen $20-200 für GitHub Copilot/Cursor

Ihr Code verlässt nie Ihren Rechner

Keine Rate-Limits

Was brauchen Sie?

Hardware:

Minimum: RTX 4060 Ti (16 GB)

Optimal: RTX 4090 (24 GB)

Mac: M2 Pro/Max mit 32+ GB RAM

Modell (Update): ⭐ Qwen 2.5 Coder 14B

Spezialisiert auf Code (92+ Sprachen)

Schlägt in Tests oft sogar GPT-4o

Alternative für schwache PCs: Qwen 2.5 Coder 7B

Format:

NVIDIA: AWQ 4-bit (beste Qualität für Code)

Mac: GGUF Q4_K_M

Was bekommen Sie?

Geschwindigkeit: 83 tok/s (RTX 4090)

Qualität: 95% von GitHub Copilot

Kosten: 0€/Monat

USE CASE 2: Automatische Daten-Extraktion

Was wollen Sie erreichen?

Hunderte PDFs/Rechnungen verarbeiten

Strukturierte Daten extrahieren

Direkt in Excel/Datenbank importieren

Kein manuelles Abtippen mehr!

Was brauchen Sie?

Hardware:

Minimum: RTX 3060 (12 GB)

Mac: M1/M2 mit 16+ GB

Modell (Update): ⭐ Llama 3.1 8B Instruct (oder Qwen 2.5 7B)

Unterstützt "Native Structured Output"

Geheimtipp: Phi-3.5 Mini (extrem schnell für Massenverarbeitung auf Laptops)

Format:

NVIDIA: EXL2 4.0 bpw (maximale Speed!)

Mac: GGUF Q4_K_M

Beispiel-Output: Input: PDF-Rechnung (unstrukturiert) Output:

{"invoice_nr": "2024-0815", "total": 428.40}

USE CASE 3: Smart Home / API-Automatisierung

Was wollen Sie erreichen?

Sprachbefehle verstehen ("Mach das Licht an")

API-Calls generieren (Philips Hue, Home Assistant)

Komplexe Automation

Alles lokal, keine Cloud!

Was brauchen Sie?

Hardware:

Minimum: RTX 3070 (8 GB)

Modell (Update): ⭐ Hermes 3 (Llama-3.1 8B)

Spezialist für "Agentic Behavior"

Versteht komplexe API-Strukturen und Function Calling besser als das Standard-Modell

Format:

NVIDIA: GPTQ 4-bit

Mac: GGUF Q4_K_M

Beispiel: Sie sagen: "Dimm das Wohnzimmerlicht auf 30%" Modell denkt:

{"function": "set_light", "room": "wohnzimmer", "brightness": 30}

System führt aus → Licht dimmt sich!

USE CASE 4: Content & Kreatives Schreiben

Was wollen Sie erreichen?

Blog-Artikel generieren

Produkt-Beschreibungen erstellen

SEO-optimierte Texte

Natürlich klingende E-Mails

Was brauchen Sie?

Hardware:

Minimum: RTX 3060 (12 GB)

Mac: M1/M2 mit 16 GB

Modell (Wichtiges Update): ⭐ Gemma 2 9B Instruct (von Google)

Llama klingt oft roboterhaft ("delve", "tapestry").

Gemma 2 schreibt deutlich menschlicher, kreativer und lebendiger.

Perfekte Größe für Heim-PCs (9B).

Format:

NVIDIA: AWQ 4-bit (beste Qualität)

Mac: GGUF Q5_K_M (etwas bessere Qualität)

Was bekommen Sie? Qualität: 90% von einem professionellen Texter, aber in Sekunden.

USE CASE 5: Intelligenter Chatbot / Support

Was wollen Sie erreichen?

Kunden-Support automatisieren

Fragen zu Bestellungen beantworten

24/7 verfügbar, 100% privat

Was brauchen Sie?

Hardware:

Minimum: RTX 3060 (12 GB)

Optimal: RTX 4070 (12 GB)

Modell (Sweet Spot): ⭐ Mistral NeMo 12B

Füllt die Lücke zwischen 8B (zu dumm) und 70B (zu teuer).

Passt perfekt in 12 GB VRAM.

Deutlich intelligenteres Kontext-Verständnis.

Format:

NVIDIA: EXL2 4.0 bpw

Mac: GGUF Q4_K_M

Beispiel-Dialog: Kunde: "Wo ist meine Bestellung #12345?" Bot: [Analysiert → Erkennt: order_status_query] → [Fragt Datenbank ab] → "Ihre Bestellung kommt morgen!"

🎓 Teil 4: Entscheidungshilfen

Welche Hardware brauche ich?

Sie haben einen Gaming-PC mit NVIDIA-Grafikkarte:

RTX 4090 (24 GB):

✅ Alle Modelle bis 14B problemlos

✅ Qwen 2.5 32B (4-bit) möglich!

✅ Llama 3.1 70B (stark komprimiert mit EXL2)

→ Format: EXL2 oder AWQ

RTX 4080 / 4070 Ti (16 GB):

✅ Qwen 2.5 Coder 14B perfekt

✅ Mistral NeMo 12B

⚠️ 30B+ Modelle schwierig

→ Format: EXL2 oder GPTQ

RTX 3060 / 4070 (12 GB):

✅ Mistral NeMo 12B (der perfekte Match!)

✅ Alle 7-9B Modelle (Gemma 2, Llama 3.1)

→ Format: GGUF Q4_K_M oder EXL2

Sie haben einen Mac:

Mac M3/M2 Ultra (64-192 GB):

✅ Auch 70B Modelle möglich!

→ Format: GGUF Q4_K_M

Mac M3/M2 Max (32-96 GB):

✅ Bis 30B Modelle (z.B. Qwen 2.5 32B)

→ Format: GGUF Q4_K_M

Mac M3/M2 Pro (16-32 GB):

✅ 7-14B Modelle (Qwen 14B, Mistral NeMo 12B)

→ Format: GGUF Q4_K_M

Mac M1 (8-16 GB):

✅ Nur 7-9B Modelle (Gemma 2, Llama 3.1, Phi-3.5)

→ Format: GGUF Q4_K_M

Sie haben nur CPU (keine GPU):

⚠️ Sehr langsam, aber möglich:

Moderne CPU:

✅ Phi-3.5 Mini (3.8B) läuft sehr gut!

→ Format: GGUF Q4_K_M

Welches Format für mich?

Schnelle Entscheidung:

ICH HABE... | ICH NUTZE... |

|---|---|

NVIDIA RTX 4090 | EXL2 4.0 bpw ⭐ |

NVIDIA RTX 4070-4080 | GPTQ oder EXL2 |

NVIDIA RTX 3060-3090 | GPTQ 4-bit |

Mac (beliebig) | GGUF Q4_K_M |

AMD GPU | GGUF Q4_K_M |

Nur CPU | GGUF Q4_K_M |

Production/Multi-User | AWQ 4-bit + vLLM |

Welches Modell für welchen Zweck? (2025 Edition)

Für Code-Generierung:

Qwen 2.5 Coder 14B ⭐⭐⭐⭐⭐ (Der neue Standard)

DeepSeek Coder V2 16B ⭐⭐⭐⭐

Qwen 2.5 Coder 7B ⭐⭐⭐⭐ (Für Laptops)

Für JSON / Strukturierte Daten:

Llama 3.1 8B Instruct ⭐⭐⭐⭐⭐ (Native JSON Support)

Qwen 2.5 7B ⭐⭐⭐⭐⭐

Phi-3.5 Mini ⭐⭐⭐⭐ (Bei riesigen Datenmengen)

Für deutsche Texte & Kreatives:

Gemma 2 9B ⭐⭐⭐⭐⭐ (Sehr menschlich)

Llama 3.1 8B ⭐⭐⭐⭐

Mistral NeMo 12B ⭐⭐⭐⭐

Für Allround-Nutzung:

Llama 3.1 8B ⭐⭐⭐⭐⭐ (Große Community)

Mistral NeMo 12B ⭐⭐⭐⭐⭐ (Beste Intelligenz/Größe)

Qwen 2.5 7B ⭐⭐⭐⭐⭐ (Sehr vielseitig)

📚 Teil 5: Das komplette Glossar

Basis-Begriffe

LLM = Large Language Model Große künstliche Intelligenz die Sprache versteht. Beispiele: ChatGPT, Claude, Llama, Qwen.

Parameter Die "Größe" eines Modells in Milliarden Zahlen. 8B = 8 Milliarden, 70B = 70 Milliarden. Mehr Parameter = intelligenter, aber größer.

Token Ein "Wort-Stück" - wie das Modell Text verarbeitet. ~1,3 Tokens pro deutsches Wort. "Hallo Welt" = ~2-3 Tokens.

tok/s = Tokens per Second Geschwindigkeit: Wie viele Wort-Stücke pro Sekunde. 100 tok/s ≈ 75 Wörter/Sekunde.

Inference Wenn das Modell eine Antwort generiert. NICHT das Training!

Context Window Wie viel Text das Modell "im Gedächtnis" behält. 128K = Ein ganzes Buch.

Hardware-Begriffe

GPU = Graphics Processing Unit Grafikkarte - viel schneller als CPU für KI. Beispiele: NVIDIA RTX 4090, AMD Radeon.

CPU = Central Processing Unit Der "normale" Prozessor. Kann LLMs nutzen, aber 10-100x langsamer.

VRAM = Video RAM Speicher AUF der Grafikkarte. Das wichtigste Limit! Das Modell muss ins VRAM passen.

CUDA NVIDIAs Programmiersprache für GPUs. Meiste LLM-Software braucht CUDA (Nur NVIDIA!).

Metal Apples GPU-Programmiersprache (Für Mac M-Chips).

Quantisierung

Quantisierung / Quantization Kompression: Modelle kleiner machen. Weniger Speicher, schneller, minimaler Qualitätsverlust.

FP16 Original-Genauigkeit (16 GB für ein 8B-Modell).

4-bit / INT4 Stark komprimiert (4 GB für ein 8B-Modell). Sweet Spot!

bpw = bits per weight Durchschnittliche Bits pro Zahl. Bei EXL2: 4.0 bpw = gute Balance.

Formate

GGUF Universal-Format (Mac, Windows, Linux).

GPTQ NVIDIA-optimierte Kompression.

EXL2 Intelligente variable Kompression. Schnellste Option für NVIDIA.

AWQ Beste Qualität bei 4-Bit.

Software

llama.cpp Sehr beliebtes LLM-Programm. Funktioniert überall. Nutzt GGUF.

LM Studio Benutzerfreundliche Oberfläche (wie ChatGPT) für den PC.

vLLM Production-System für LLMs. Multi-User, sehr schnell.

Ollama Sehr einfaches Tool. "Docker für LLMs". Nutzt GGUF.

JSON & APIs

JSON Standard für strukturierte Daten (

{"name": "Max"}).Function Calling Modell kann "Funktionen" aufrufen (z.B. Wetter-API, Datenbank).

Structured Output Antwort folgt festem Schema. Garantiert gültiges Format.

✅ Zusammenfassung: Die wichtigsten Erkenntnisse

Das Kern-Prinzip: Große Modelle (140 GB) → Kompression → Kleine Modelle (4 GB) 4-Bit = Sweet Spot! (80-85% Qualität bei 25% Größe)

Die vier Formate:

GGUF: Universal, funktioniert überall

GPTQ: NVIDIA-schnell, 30-60% faster

EXL2: NVIDIA-schnellste, intelligente Kompression

AWQ: Beste Qualität, für Production

Die Top-Modelle heute (2025):

Coding: Qwen 2.5 Coder 14B

Daten: Llama 3.1 8B / Qwen 2.5

Content: Gemma 2 9B

Chatbot: Mistral NeMo 12B

Laptop: Phi-3.5 Mini

🎯 Ihr nächster Schritt

Sie haben jetzt das komplette Wissen! Aber wo anfangen?

Meine Empfehlung für absolute Anfänger:

Schritt 1: Hardware prüfen

Habe ich eine NVIDIA GPU mit 12+ GB? → EXL2 oder GPTQ

Habe ich einen Mac mit M-Chip? → GGUF

Habe ich nur eine CPU? → GGUF (langsam)

Schritt 2: Einfaches Tool installieren → Ollama (am einfachsten!) oder → LM Studio (GUI, sehr anfängerfreundlich)

Schritt 3: Erstes Modell testen Empfehlung: Gemma 2 9B (für kreative) oder Llama 3.1 8B (für sachliche Aufgaben). Version: Q4_K_M.

🙏 Schlusswort

Der LLM-Dschungel ist nicht mehr so dicht, oder? 🌴 Dennoch kann man auch bei diesen Inhalten in die Tiefe gehen.

Was Sie jetzt wissen:

✅ Warum Modelle komprimiert werden müssen

✅ Was 4-Bit bedeutet (und warum es der Sweet Spot ist)

✅ Die 4 Haupt-Formate (GGUF, GPTQ, EXL2, AWQ)

✅ Welches Format für welche Hardware

✅ Die besten Modelle für 5 konkrete Use Cases

✅ Alle Fachbegriffe in einfachen Worten

Viel Erfolg bei Ihrer LLM-Reise!